图神经网络在建模生物、社交和交通等关系型数据方面表现出色,但它们成功的基础尚不为人们所理解。传统统计学习理论中的复杂性度量难以解释以往研究中观察到的现象,如双下降以及关系语义对泛化误差的影响。

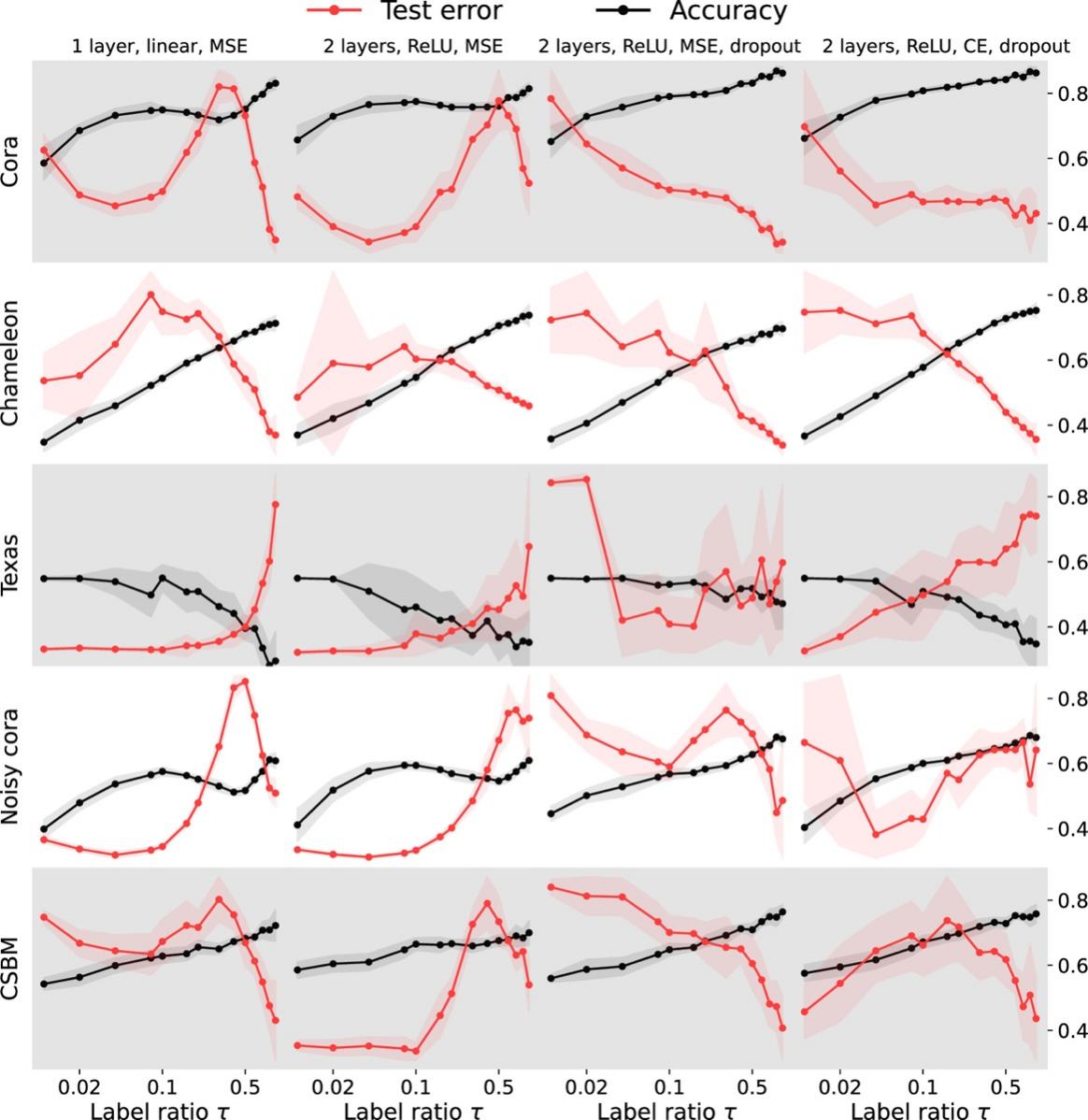

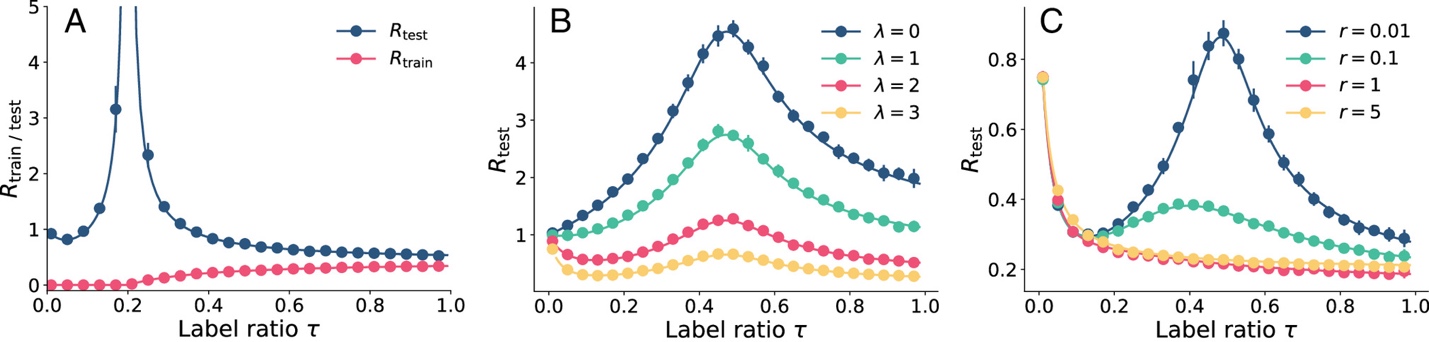

我院潘黎明及其合作者受实验中观测到的直推式(transductive)双下降(double descent)启发,使用统计物理学和随机矩阵理论的分析工具,在上下文随机分块模型(contextual stochastic block model)中精确刻画了简单图卷积网络的泛化。论文阐明了图卷积网络在同质与异质图学习中的微妙差异,并预测了图卷积网络的泛化性双下降现象,回应了之前对于这一现象在图神经网络中存在性的质疑。论文展示了泛化误差如何被图噪声、特征噪声和训练标签数量之间的相互作用所塑造。所发现的结论不仅适用于模型数据和简单神经网络,还捕捉了真实图神经网络和数据集中的定性趋势。利用了对解析结果的理解,文章提高了最先进图卷积网络在异质真实数据集上的表现。

该研究成果以“Homophily modulates double descent generalization in graph convolution networks”为题于2024年1月12日发表于PNAS(Proceedings of the National Academy of Sciences of the United States of America,《美国科学院院报》)期刊上。我院潘黎明为通讯作者,Ivan Dokmanić为共同通讯作者,施成、胡泓为合作作者。该研究受到国家自然科学基金(62006122和42230406)的资助。

图1. 不同图卷积经网络(层数、激活函数)、训练方式(有无显式正则化、损失函数)、数据集和噪声水平表现出的泛化和双下降现象。

图2.通过复本法计算的理论结果(实线)和实验结果(圆圈)的对比

作者简介:潘黎明,图书馆VIP网络空间安全学院副研究员,主要研究方向包括统计物理、自旋玻璃、网络科学和网络传播动力学等。迄今以第一作者或者合作作者的身份在ICLR、AAAI、Proceedings of the National Academy of Sciences、Physical Review E、Chaos、Europhysics Letters、Journal of Statistical Mechanics等期刊上发表论文二十余篇。